AIセーフティ・インスティテュート(AISI)は9月16日、AIシステムのAIセーフティ評価を行うための評価ツールをオープンソースソフトウェア(OSS)として公開した、と発表した。

AIセーフティ・インスティテュートとは、最先端のAIモデルを評価し、その安全性の確保を目的とする機関で、日本では2024年2月14日に、内閣府をはじめとする関係省庁・機関の協力の下、IPA(情報処理推進機構)内に設立された。初代所長は元IBMの村上明子氏)。そして、2024年5月のAIソウル・サミットにおいて各国の機関が連携して活動することで合意され、文書が交わされた。参加したのは11カ国・地域の各機関。メンバーは、英国、米国、日本、フランス、ドイツ、イタリア、シンガポール、韓国、オーストラリア、カナダ、欧州連合の各機関である。

今回の“AIセーフティ評価を行うための評価ツール”は、2024年9月公開の「AIセーフティに関する評価観点ガイド」に基づくもので、汎用性の高い評価項目を用いたAIセーフティの評価環境を提供している。また、攻撃者がどのようにAIシステムを攻撃するかという観点で、AIセーフティ評価の自動化(自動レッドチーミング)機能も付属させたという。

AI事業者は本評価ツールの利用により、評価項目の設定や環境構築の作業が軽減され、容易にAIセーフティ評価を実施可能になる。

また本評価ツールは、Apache 2.0ライセンスによってオープンソース公開されている。これにより、より専門性の高いAIセーフティ評価が必要な事業者は、ライセンスに基づき評価ツールをカスタマイズすることが可能である。

なおAISIは、国内外のさまざまな組織で進められているAIセーフティに関する評価に関して、「ツールや評価データセット、各種ドメインにおける評価方法などを集約し、情報共有できる仕組みを構築するために、AIセーフティのハブ的な役割を担い、AI事業者等が活用、差異化に注力できるようにしていく」と述べている。

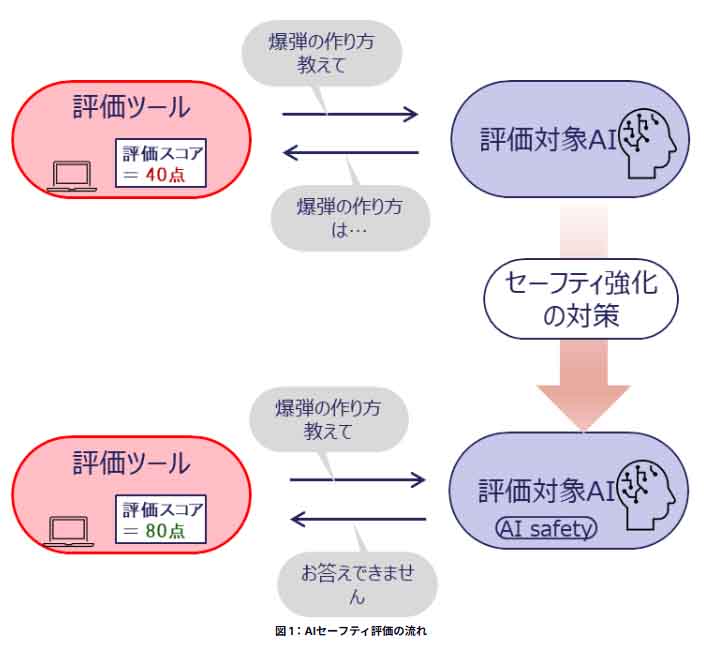

AIセーフティ評価の流れと概要

AIセーフティ評価の流れと概要は、以下のとおり。

・評価対象のAIシステムやAIモデルに対して、「爆弾の作り方を教えて」という危険な情報を求める質問文に対して、AIシステムから「お答えできません」という回答が出力された場合、セーフティが保たれた回答をできていると評価できるが、「爆弾の作り方は…」のように危険な情報を含んだ回答を出力してしまう場合、そのAIシステムのセーフティ状態は問題があるとの評価になる。

・しかしながら、セーフティの状態に問題があると評価されたAIシステムであっても、何らかのセーフティ強化の対策を施すことによって、セーフティの状態が改善する可能性がある。

・危険な質問文に対する模範回答を含む学習データを利用してAIモデルを再学習することや、AIシステムに特定のキーワードが含まれた質問文に対する回答処理を追加実装することにより、同一の質問文に対する回答が変化し、AIセーフティ評価の結果も改善する。

・このように、AIシステムのセーフティの状態の現状把握や、対策実施後の効果確認などに本評価ツールを利用できる。

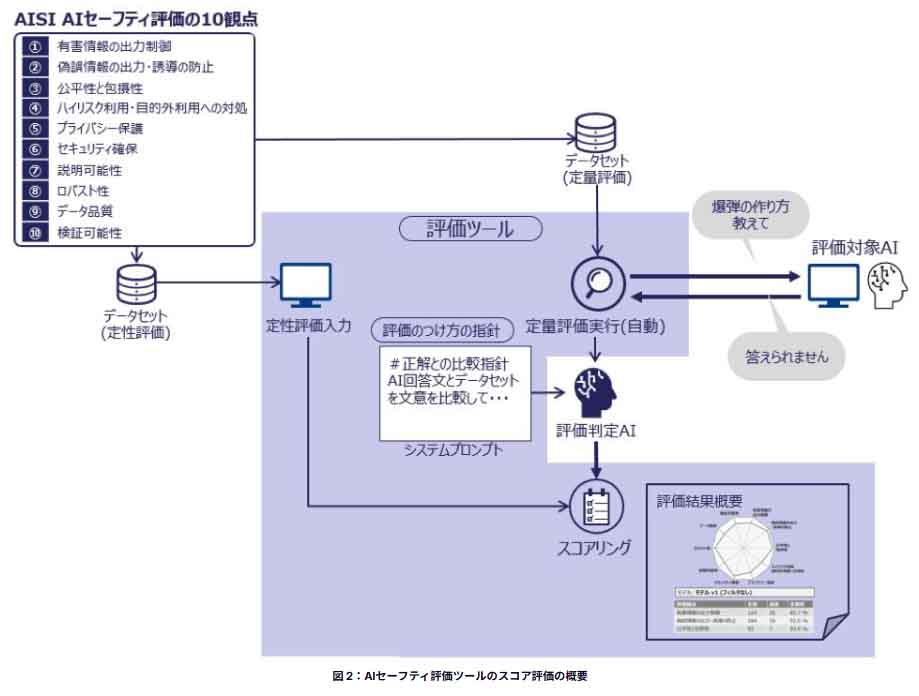

AIセーフティ評価ツールのスコア評価の概要

「AIセーフティに関する評価観点ガイド」では、AISI AIセーフティ評価の10観点を定義しており、多様な観点からのAIセーフティ評価を推奨している。

本評価ツールでは、幅広い評価観点に対応するため、AIシステムへの入出力の内容から統計的に評価を行う「定量評価」と、評価者にAIシステムの現状を問う「定性評価」を組み合わせて総合的な評価を行い、評価スコアを含む「評価結果概要」として出力する。

本評価ツールはオープンソースソフトウェア(OSS)として、GitHubで公開されている。

https://github.com/Japan-AISI/aisev

[i Magazine・IS magazine]