最新技術の結晶として登場するエンタープライズサーバー。IBM Power E1080はプロセッサレベルからシステム全体を設計し直し、従来の企業向けサーバーの性能・機能を大きく上回る高性能サーバーを実現した。間々田隆介 IBM Power事業部 製品統括部長に、IBM Power E1080の最新技術を解説していただく。

間々田 隆介氏

日本アイ・ビー・エム株式会社

テクノロジー事業本部 IBM Power事業部

製品統括部長

IBM Power E1080が実現した

3つの技術革新

i Mag IBM Power E1080(以下、E1080)の技術的なハイライトからお話しいただけますか。

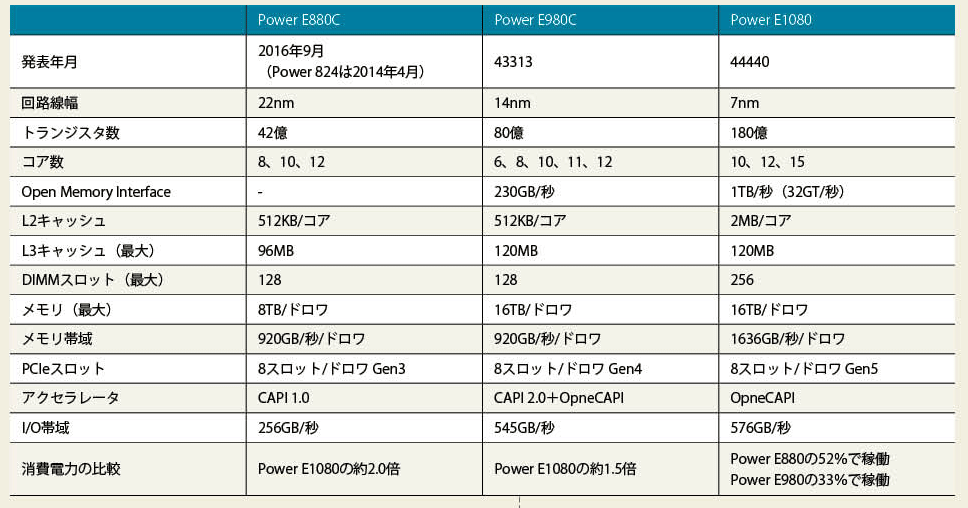

間々田 Power E1080はチップレベルから設計し直したマシンで、半導体チップの世代で言うと2世代進んだものになります。つまり半導体の集積度が4倍になり(1世代更新を2倍と計算)、チップの面積が同じなら4倍のトランジスタを積むことが可能です。メーカーはその増えたスペースに何を搭載するかが腕の見せどころですが、IBMは今回ハイブリッドクラウドの進展とAIの本格的な普及を見越して革新的な技術をいろいろと実装しました(図表1)。

i Mag 代表的なものは何ですか。

間々田 1つは新しいメモリインターフェースの導入による帯域幅の大幅な拡大、2つ目はCPUコアへのAI推論エンジンの搭載、3つ目は画期的な暗号機能の搭載とセキュリティの強化です。もう1つ、クラスター化したサーバー間でメモリを共有する機能がありますが、これは次のPower10サーバーの発表時にリリースする予定です。

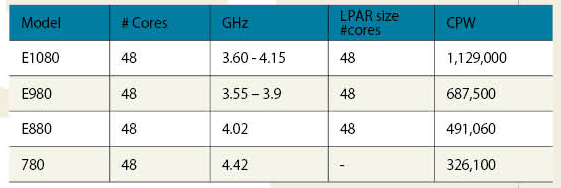

Power10ではプロセッサの線幅をPower9の半分の7nm(ナノメートル)にし、トランジスタ数をPower9(80億個)の2倍以上(180億個)に引き上げました。これにより処理性能は、CPW値でPower9の1.6倍、Power8の2.3倍になっています(図表2)。

そしてさらにCPU単体の性能向上だけでなく、CPUとメモリをつなぐインターフェースの帯域幅も拡大し、システム全体で処理性能が大きく向上する実装を行いました。そのインターフェースがOpen Memory Interface(OMI)です。

OMIはチップあたり16チャンネルを搭載し、1TB/sの帯域幅を実現します。これはPower9(230GB/s)の4倍以上にもなります。そしてメモリインターフェースの高速化とともに重要なのが、「ディファレンシャルDIMM(DDIMM)」という信頼性が非常に高いメモリの採用です。

最近はメモリ上に大規模なプログラムを展開するインメモリ型のアプリケーションや、多様なサービスを連携させて処理する複雑なアプリケーションが増えつつあります。そうなるとCPUの高性能化やメモリの大容量化と高信頼化、CPUとメモリをつなぐインターフェースの広帯域化がきわめて重要になります。E1080はそれらすべてをバランスよく実現したシステムで、とくにハイブリッドクラウドとAIの領域で、サーバーとしての適用範囲を大きく拡大するマシンになっています。

(PDFのダウンロードはこちらから)

基幹サーバー上でGPUなしに

AI推論処理できる画期性

i Mag 2つ目のAI推論エンジンの搭載はどのようなものですか。

間々田 今回の新機能をご理解いただくために少し遡ってお話すると、日本で「ディープラーニング元年」を言われたのは2016年です。このときは画像処理や数値データの機械学習、自然言語処理が中心で、IBMは「Minsky(ミンスキー)」と呼ぶGPU(NVIDIA)搭載のIBM Power System S822LC for HPCをリリースしました。これは、AI処理するデータをPowerから外部へ出すのではなく、Power上で処理を完結させるのが目的でした。AI処理するデータを外へ出すと、システムが複雑になって手間がかかるうえに、筐体間でかなりの電力を消費します。その問題を解決したMinskyは、当時としては非常に画期的なマシンだったのです。

ただし、同一筐体内にCPUとGPUがあると効率は抜群にいいものの、特別なプログラミングが必要になり、それなりの技術が要求されるという問題は残りました。

ところでAI処理を学習と推論に分けると、GPUが必要になるのは大量のデータの計算処理が必須となる学習フェーズのほうです。推論フェーズのほうはもっとライトウェイトな環境で十分なのです。

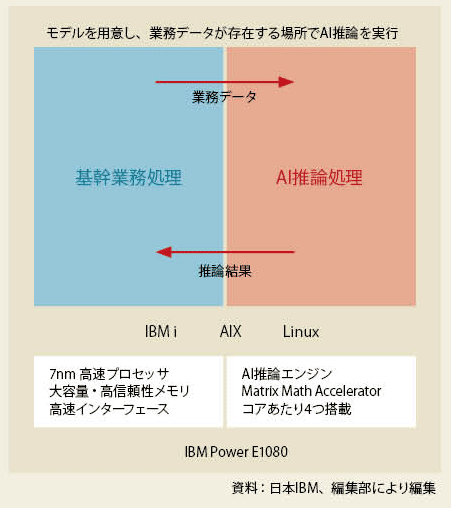

そこでAI推論用のエンジンをCPUコア上に搭載し、GPUや特別なプログラミングなしにAI推論処理が行える仕組みが構想されました。それがE1080で、E1080は基幹業務処理のすぐ隣で、基幹データを利用してAI推論処理が行えます。AI処理をぐっと身近にするシステムだろうと思います。

i Mag そのAI推論エンジンは「Matrix Math Accelerator(MMA)エンジン」というのですね。

間々田 CPUのコアごとに4つのMMAを搭載しています。それをPower E980のAI推論能力と比較すると、約20倍の性能を出すことも可能です。それとオープンソースのライブラリ「ONNX(Open Neural Network Exchange)」をサポートしているので、ONNX対応の学習済みAIモデルなら、コードの変更はまったくなしに、x86サーバーなどからPower E1080へのデプロイが可能です。これもAI処理を身近にする大きな特徴でしょう(図表3)。

CPUとメモリ間で

データを自動で暗号化

i Mag 次はセキュリティのご説明をお願いします。

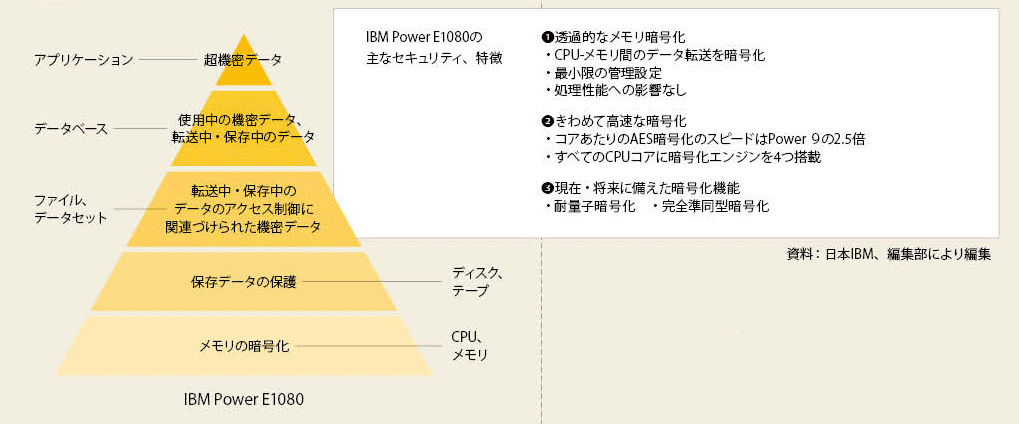

間々田 E1080で搭載した新機能の1つは、「透過的なメモリ暗号化」というものです。聞き慣れないかもしれませんが、アプリケーションを実行すると、CPUとメモリ間で自動的にデータや命令を暗号化してしまう機能です。アプリケーション側で暗号化する必要がないのが大きなメリットで、CPUからメモリを見るとすべて暗号化されている状態です。これによって、メモリバスを監視してデータを読み取るとか、メモリモジュールを詐取して中身を抜き取ろうというようなサイバー攻撃に完璧に対処できます。

この暗号化エンジンはCPUコアごとにPower 9の4倍に増強されています。先ほどメモリモジュールの信頼性に触れましたが、この暗号化エンジンもE1080のメモリの信頼性向上に大きく貢献しています。この暗号化エンジンによるシステム処理への影響がまったくないのもいい点です。

そのほかCPUの性能向上に伴って、AESの暗号化ではPower E980の2.5倍の高速処理を実現しています。また、将来への備えとして、量子コンピュータを使った暗号解読アタックに対応する「耐量子暗号化」や「完全準同型暗号化」機能にも対応可能になっています。

E1080のセキュリティの特徴を一言で言うならば、システムの心臓部であるCPUコアからシステムを展開するクラウドまでデータを守るセキュリティ機能をいっそう強化した、となると思います(図表4)。

2PBのメモリを共有する設計

アプリケーションの作り方が変わる

i Mag 間々田さんは、5250のマイクロコードの開発エンジニアや半導体事業部やHPC(ハイパフォーマンス・コンピューティング)分野で技術営業を務めてこられたとのことですが、エンジニアから見てE1080で注目したのは何ですか。

間々田 もう7nmのシステムを出してきたか、凄いな、というのが率直な感想でした。IBMは半導体事業の製造部門を2014年に売却したのですが、そのことによって自社の製造能力に縛られない、自由な半導体の設計・開発が可能になりました。つまり、その時々の最先端の製造能力をもつパートナーに製造を委託するという方針によって、設計の幅が大きく広がったのです。

今回は製造プロセスを7nmに細線化してチップ上にスペースを生み出し、そこに革新的な機能をさまざま搭載しましたが、それを可能にしたのは今回製造を委託したサムソン電子の技術があったからこそのことです。とくに高い電圧をかけても壊れないRISCプロセッサのよさをふんだんに盛り込んだ、見事な設計・製造になっていると思います。

i Mag 最後に、今回は発表されなかったサーバー間でメモリを共有する機能について概略を教えていただけますか。

間々田 クラスタ化したサーバー間でメモリを共有できると、アプリケーションからはメモリの制約がないように見えます。サーバーの垣根がなくなるようなイメージです。今後はアプリケーションの作り方がマイクロサービス対応になっていくでしょうから、いろいろなサーバーのメモリ上にある多種多様なマイクロサービスを適宜呼び出してプログラムを実行するような使い方が現実のものになるはずです。昨年8月にPower10プロセッサの詳細が公開されたときには、2PB(ペタバイト)のメモリが共有可能になるとのことでした。そうなるとアプリケーションの作り方自体が変わるでしょう。Power10サーバーはこれまでにない可能性を秘めたマシンだと思います。

[i Magazine・IS magazine]