Text=岡本 茂久 日本アイ・ビー・エム システムズ・エンジニアリング

空間コンピューティングとは

Appleが2023月6月、新しいデバイス「VisionPro」を発表したことは記憶に新しい。

ジャンルとしてはAR/MRデバイスだが、Appleは今回のデバイスでできることを「空間コンピューティング」と位置づけている。従来のXRとどう違うのだろうか。

空間コンピューティング(Spatial Computing)は、そもそも新しい言葉・概念ではない。MRデバイスである MagicLeapやMicrosoftのHoloLensが登場した頃から使われており、もともとは2003年にMITメディアラボOBのサイモン・グリーンウォルド氏によって初めて、「機械が実際のオブジェクトや空間への参照を保持し、操作する機械との人間の相互作用」と定義されていた(『Spatial Computing』 Simon Greenwold)。

その意味で、空間コンピューティングは「XR技術をテクノロジー手段に用いたコンピューティング形態」とも言えるし、広義にはアプリとしてのメタバースなどを含む「XR」と同等の言葉とも捉えられる。しかしAppleはVisionProの発表の際に、「XR」という言葉を用いなかった。「物理的な空間をコンピュータのインターフェースとして利用することで、PCなど機械の固定された場所に縛られる必要がない」という本来の意味に着目していると考えられる。

発表会の場で実際にVisionProを体験してきたというジャーナリストの西田宗千佳氏は、ディスプレイの存在に着目している。西田氏によれば、今までのディスプレイは、「平面に情報を映し出すもの」であり、我々は「実世界の中に置かれたディスプレイを見る」形で過ごしており、3D表現も見かけ上のものだった。

しかし視界をディスプレイで覆うHMD(Head Mounted Display:ヘッドマウントディスプレイ)により、「HMDの中に描かれた空間を『もう一つの現実』と感じられるような体験ができる」「Vision Proでは映像の中にウインドウや3Dオブジェクトを重ね、『現実の中にアプリが浮いている』世界を実現している」と指摘する(「Apple Vision Pro」へ至る空間コンピューティングの歴史、西田宗千佳)

つまりディスプレイが視界を覆い、コンピューティングしているユーザー自身もその中に入っている状態である。この「空間」が仮想現実なのか、あるいは「リアルな現実」かの違いだが、Appleは後者に重きを置いているように思える。

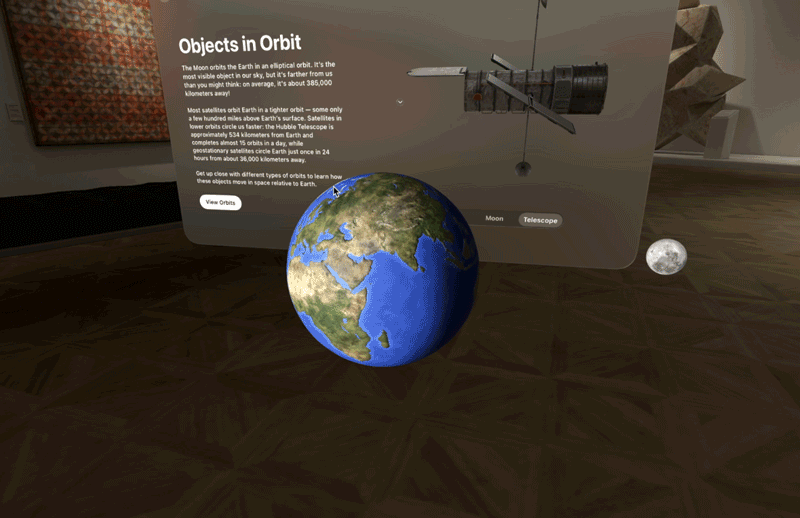

図表1はAppleから提供されているVisionOSベータ版のSDKと、開発環境Xcodeのシミュレータで実際にデモを動かしてキャプチャした画像である。

アイコンやアプリ画面が宙に浮かび、埋め込まれた3Dオブジェクトが飛び出てくる。背景はシミュレータが用意しているのだが、3次元で表現されており、視点をある程度移動できる。

冒頭の問いにとりあえずの回答を検討すると、「XR」はVRやAR、MRといった現実世界とデジタルの仮想要素を組み合わせる技術を包括する言葉だが、「空間コンピューティング」はそのXR技術を用いながら、現実空間をデジタル情報へ統合するアプローチということになる。

Appleは今回のデバイスの革新的な要素でもって、従来の「XR」との差別化を図りたかった、あるいはiPhoneがスマートフォンをそうしたように、「空間コンピューティング」という言葉、あるいはコンピューティング環境そのものを「再定義」したかったと考えられる。

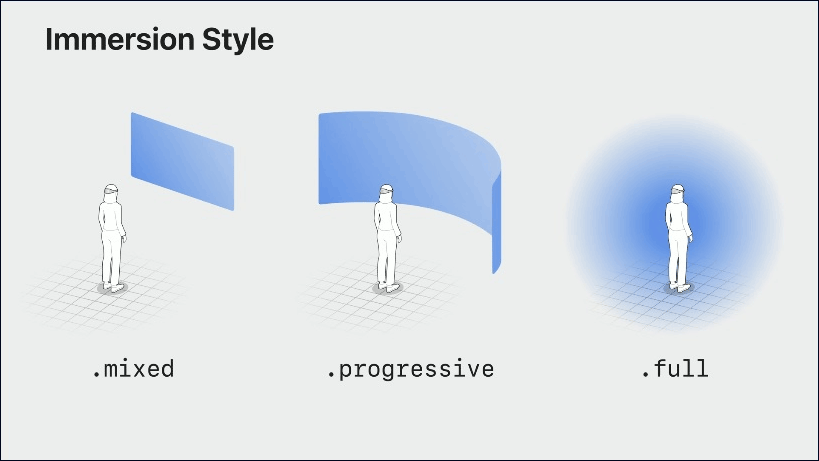

Appleの発表ではほかに、「イマージョン」(immersion)や「イマーシブ」(immersive) といったキーワードが多用されており(どちらも「没入した、実体験の」という意味)、VisionPro用に設計されたVisionOSでは、アプリのシチュエーションが実質ARなのかVRなのかをイマーシブの度合いで表現するようになっている。

HMD:空間コンピューティングのデバイス

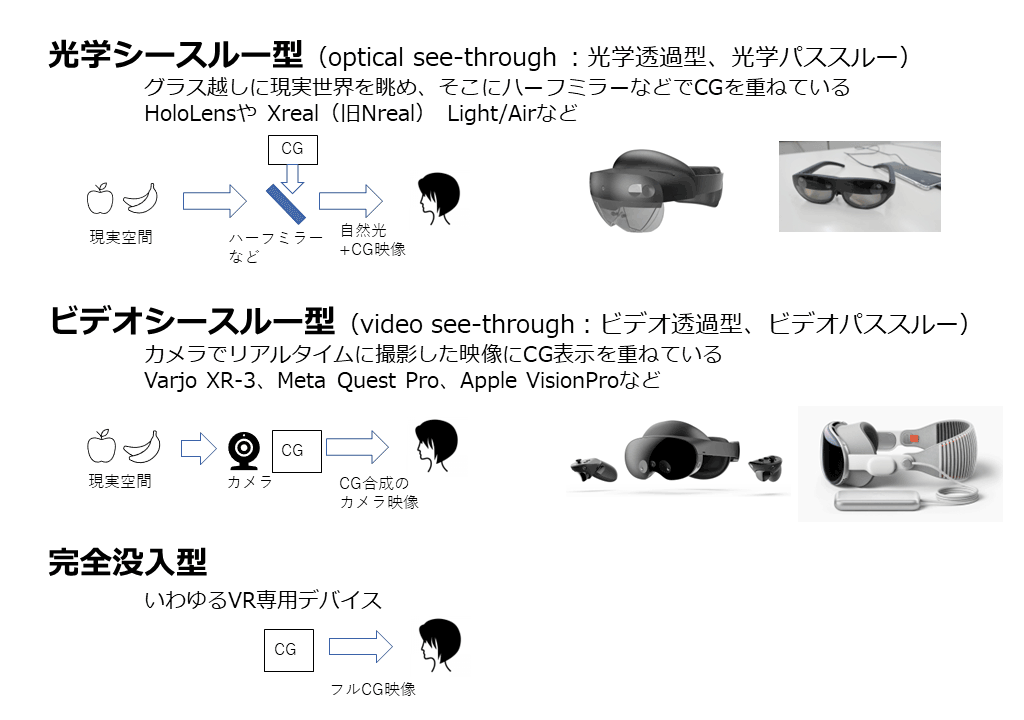

最近のHMDのトレンドとして、表示部分がグラスで周囲の現実をそのまま見ることのできる「光学シースルー方式」ではなく、カメラで撮影した映像にデジタル表示を重ねる「ビデオシースルー方式」を採用したデバイスの登場が相次いでいる(「ビデオシースルー型とは? VR/AR/MRにおける3つのHMDディスプレイタイプを解説」)。VisionProも、後者に分類される(図表2)。

光学シースルー方式は実世界の見え方が自然であるという利点があり、一方のビデオシースルー方式は合成結果が均質でさまざまな画像処理の適用に向く利点がある(『バーチャルリアリティ学』日本バーチャルリアリティ学会編 コロナ社刊、第5章 リアルとバーチャルの融合-複合現実感、より)。

また光学シースルー方式はその構造上、重畳したデジタル表示が半透明で、輝度によっては透けて見え、視野角の境目も現実の中に現れるので、没入感が削がれるシーンもある。

これに対してビデオシースルー方式は、映像の融合レベルが高いものの、リアルタイムとは言えいったんカメラ映像としての処理が入っているので、現実からタイムラグが生じる。ただしVisionProはこのあたり、ズレや歪みがほとんどなく、気にならないくらいの精度を実現しているという。ちなみにスマートフォンやタブレットで稼働するARアプリなども、いったんカメラ映像を介するビデオシースルー方式である。

VRデバイスであるMeta(旧Oculus) Quest1/2も、ビデオシースルー機能(パススルーモード)を搭載しているが、プレイ中に周囲の家具にぶつからないようにするといったリスク回避が狙いであり、解像度の低いモノクロ映像であった。

しかしMetaのVR会議サービス「Horizon Workrooms」では、指定された物理キーボードをVR内で利用できるほか、指定されていない物理キーボードでも、手元だけ切り抜いて現実空間を映したシースルー映像にして、VR会議空間で他のリモートユーザーとコミュニケーションしながら、議事録を取るなどのタイピング作業が可能であった。この場合、ディスプレイ部分はVR内に表示している(「Meta Horizon WorkroomsのVRでキーボードを使用する」)。これは、「VR空間で現実のPC作業をする」という空間コンピューティングの試みの一例である。

2022年に発売されたMeta Quest Proでは、このビデオシースルー映像がカラーになり、さらに実用的になっている。この路線は、2023年内に発売予定のMeta Quest 3でも踏襲される予定である。

このようにHMDでのビデオシースルー方式の採用は、1台でVRアプリ、ARアプリの両方に対応できる可能性を示していたが、VisionProではそこをさらに進化させ、デバイスのツマミ(デジタルクラウン)をひねることでイマーシブ度を変更できる(つまりVRとARの間を動的に行き来できる)タイプのアプリも構成可能としている。

図表3は、そのイマーシブ度によるスタイルの違いを表現している。

AppleのVisionOSから、コンテンツが現実空間に浮いたスタイル(.mixed、ARに近い)、背景まで完全に覆われたスタイル(.full、VRに近い)、およびその中間(.progressive)の可変のスタイルをアプリの「没入度」で構成する(「Get started with building apps for spatial computing – WWDC23 – Videos – Apple Developer」)。

こうして見ると、Microsoft HoloLens、Meta Questシリーズ、Apple VisionProはそれぞれMRが可能なHMDデバイスだが、利用シーンにかなり違いがあり、空間コンピューティングを実現するアプリも、以下のようにこれらの特性を活かしたものになりそうだ。

◎HoloLens

AR(MR)が主体であり、現実空間にて用いる。VR要素はない。

◎Meta Questシリーズ

VRが主体だが、AR(MR)要素も取り入れて現実とのインタラクションを取り込みつつある。

◎VisionPro

AR(MR)が主体だが、VRも可能である。

空間コンピューティングのインタラクティブ性とその他の技術要素

空間コンピューティングでは、デジタル情報と、そこに存在するユーザー自身のインタラクティブ性、入力の方式も重要である。これも、以下のように進化している。

◎ハンドトラッキング

HMDを身に着けているユーザーの手を認識し、その位置をVRやMR空間のアバターの手に反映させる。

◎アイトラッキング

瞳孔の検知から頭部に対する眼球運動を計測し、ユーザーの注意点(視線がどこを向いているのか)を判定する。

どちらも従来のデバイスに搭載されているセンサー技術で、HoloLensはアイトラッキングで見ているUIボタンなどの選択、ハンドトラッキングを応用したゼスチャーによる操作も実現している。

VisionProではこれらを組み合わせて、アイコンの指定をアイトラッキングで行い、ボタンを押すなどの操作は手元で行う様子がデモで示されている。従来のハンドコントローラーや素手のトラッキングで、空中に浮いたボタンやバーなどのユーザーインタフェースを操作する方式は、長時間実施すると腕が結構疲れる(これはPCのマウス操作でも、リストレストがないと疲れてくるのを想像すれば分かりやすい)。しかしVisionProでのアイトラッキングと指操作での入力は ひざの上に置いた手でも可能なので画期的である。

また音声での認識(Siriに対応)や、Bluetoothなどで接続したキーボード、トラックパッドでの入力も引き続き利用可能とされる。

精度の高い空間コンピューティングを行うには、デバイスは周囲の現実空間を正確に認識する必要がある。

最近は、事前に構築されたデジタル上の3Dマッピングとカメラ映像を照合し、高精度な位置情報を特定するVPS(Visual Positioning Service)技術の進展が注目されており、広範囲のMRに欠かせないSLAM(Simultaneous Localization and Mapping:自己位置推定とマッピングの同時実行)などの初期化を行う上で重要になっている。

従来のHMDも、LiDARやToFセンサーで周囲の形状を正確に把握できているが、VisionProもLiDARスキャナ、TrueDepthカメラを搭載しており、センサー情報を制御する専用のR1チップも搭載されているので、高度な位置マッピングが期待できそうだ。

VisionProのデモでは、現実世界を正確に認識し、空中に浮かんだ仮想オブジェクトの影が現実のテーブルに自然に落ちて没入感を高めていた。

このほかVisionProの特徴としては、デバイスの表面にユーザーの目を表示することで、第三者から見てどこを向いているか分かるようにしたり(EyeSight)、搭載された3Dカメラを用いて周囲の様子を3Dの静止画・動画で記録・再生する(Spatial Video)機能などが挙げられる。このSpatial Video機能は、先日発表になったiPhone15 Proにも機能アップデートで搭載される予定だ。

またここまで述べてきたHMDとは直接関係ないが、以下の技術の進展も3D環境/コンテンツの構築や空間コンピューティングの進展を後押しするだろう。

◎モーショントラッキング

VR上で身体の姿勢情報をアバターの動きに伝えるのに重要。スマートフォンの画像解析からの骨格推定や、6つの小型センサーを身体に装着して最低限の姿勢再現を行うことが可能なSONYのmocopi (https://www.sony.jp/mocopi/)など、簡易に実現可能なタイプが増えている。

◎3Dキャプチャ(3Dスキャン、自由視点映像生成)

iPhone1台で高精細な3Dスキャンが可能なアプリで、LiDARやフォトグラメトリに対応する。従来の手法では苦手な分野(半透明やメタリックで反射するもの)をAI補正で克服するNeRFや、映像から中間情報を合成する3D Gaussian Splatting、後で視点を自由に動かせる3D動画であるボリュメトリック映像など、現実空間を3Dデジタル情報として捉える技術が進展、普及している。

◎裸眼3Dディスプレイ

HMDや特殊なメガネをかけなくとも、両目の視差に対応した映像を表示して3D感、奥行き感を表示できるレンチキュラーレンズや、視線認識型ライトフィールドを採用したディスプレイが登場している。これにはSONYのELF-SRシリーズやnubia Pad 3D(Androidタブレット)、ASUS ProArt Studiobook(ノートPC)などがある。

空間コンピューティングの適用分野と可能性

空間コンピューティングは、どんな分野に適用されるだろうか。医療、教育、建築、製造現場、小売業など、これらはすでにXRのユースケースとして語られ、モバイル環境やブラウザベースのメタバースなどでも一定の成果を出してきたが、現場に物理的にマッチした状況でコンピューティングできることで、さまざまに進化する可能性がある。例えば、BtoBやBtoE、BtoCの分野で、以下のようなユースケースが考えられる。

・現場に即した没入型のトレーニングで生産性の高い教育効果を得る

・360°仮想環境での立体音響を再現する

・バーチャルAIアシスタントと自然に音声会話することで、家庭の日常生活やオフィスの通常業務を充実させる

・リモートの専門家とつながることで、専門知識の不足を補いながら現場の様子や状況を共有し、高度な業務を継続できる

・倉庫や工場などで、個々の場所で必要なデータの入手やチェック業務を直接行える

・バーチャルオフィス出社やよりインタラクティブなバーチャルリモート会議を実現する

最近は「モノ消費」から「コト消費」(体験型の消費)への移行が進んでいるとも言われており、体験そのものに価値を見出す人が増えている(「モノ消費からコト消費、さらにトキ消費へ。Z世代はイミ・エモ消費が増加」)。

例えば小売業では、効率化されたカタログ注文であるECサイトでの購入よりも、実際に身に付ける、商品がディスプレイされている様子を次々と「ウィンドーショッピング」する、他の人が注目していることに「気づく」など、買い物という体験自体に価値を見出す「バーチャルショッピング」が注目されている。

空間コンピューティングを駆使することで、この分野でも、より充実した「イマーシブな」体験を提供するポテンシャルがある。

普及への布石「ディスプレイ環境の空間化」

このような次世代のコンピューティング環境のメリットは認めつつも、「HMDのような大きなデバイスを頭部に身に付けるスタイルはなかなか定着しない」、あるいは「3Dにすぐには馴染めない」という意見も根強い。では、今後どのようにシフトチェンジしていくのだろうか。

当初、ゴーグルタイプのHMDはメガネサイズに小型化することで装着する敷居が低くなり、普及価格帯ではスマートフォンからの移行が進むと予想されていた。しかし、まだまだ小型化は進まないし、現在はスマートフォンでできることが追求されすぎて、これを手放して乗り換えるまでには至っていないのが現実だろう。

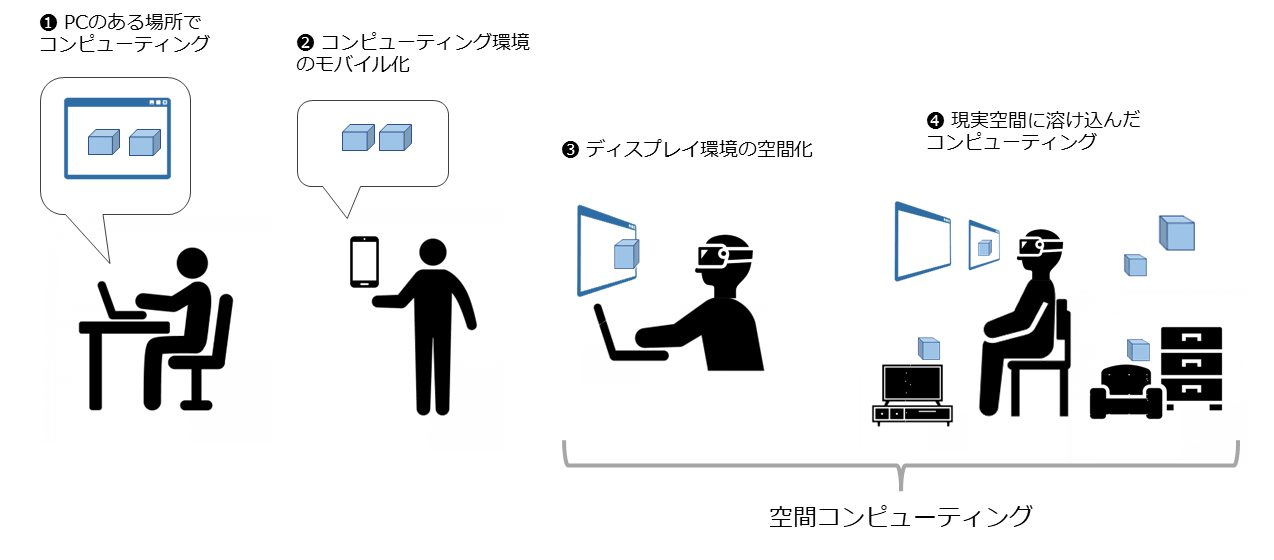

図表4は、コンピューティング環境の遷移を示した一例である。

スマートフォンの技術革新により、ユーザーはコンピューティング環境をモバイル化できるようになったが、持ち手が塞がり、情報も四角の枠の中に囚われていた。図表4の❶や❷の利用状態が現在も続いているが、XR技術を用いた❹の空間コンピューティングが目指している、デジタル情報が普遍的に現実に溶け込んだ近未来SF映画のような状態は、手にとって試すレベルまでは来ているものの、❶や❷の形態を捨ててまで乗り換えようという風潮は現時点では薄い。

そこで置き換えるのではなく、むしろスマートフォンやPCの拡張デバイス、空間上にディスプレイを1枚~複数枚表示する外部ディスプレイとしての普及が最初は進むかもしれない。

現在、手に届くARグラスとして普及しているXreal Lightは、スマートフォンと接続して用いる。アプリ稼働やバッテリーもスマートフォン側であり、グラス側はセンサーとディスプレイに特化することで軽量化を実現している。

マーカーを認識してのAR(MR)や、ハンドトラッキング入力も可能だが、MRモードのほかにスマートフォンの画面をそのまま表示する「ミラーリングモード」がある。これによりYoutubeなどのアプリやゲームを空中の大スクリーンで楽しめるようになっている。

この「身につけるホームシアター」のような使い方は受容されつつあり、後続製品で軽量化された「Xreal Air」は、こちらの用途を前面に押し出して販売され、好評を得ている。

またスマートフォンのほかに、Type-Cの端子を持つPCやタブレットでも、接続すると外部ディスプレイとして認識し、ミラーリングして、元々は小さな画面を空中に大きく描画したり、セカンドディスプレイとして元の画面と並べて利用したりできる。これは現在のPCやモバイルの、それほど敷居の高くない延長線上の利用形態である。

VisionProも使い方の1つとして、単体で用いるほかに、Macの外部ディスプレイとして使用し、コンテンツの1つとしてMacの画面を空中に指定することが可能である。

アーリーアダプターではない一般のIT利用者は、あまり3Dコンテンツに慣れておらず、最初は2D画面に配置された情報を好むだろう。VisionProのデモも、iPad用に作られた平面アプリやWebブラウザが空間に複数固定されている図が示された。

まずはこの、既存のPCやモバイルの平面画面を拡張して、空中に(複数)浮べるスタイルを享受する形での普及が進むのではないだろうか。

すなわち図表4にある、過渡期としての「❸ ディスプレイ環境の空間化」である。そうして日常的にデバイスを身に付けることのメリットを享受できたなら、情報が現実空間に沿った3D化、MR化していくという段階的な普及プランが考えられる。

冒頭に挙げたグリーンウォルド氏によれば、「空間コンピューティングが、3Dモデリングやデジタルデザインなどの関連分野と異なるのは、扱う形態や空間があらかじめ存在し、現実世界の価値を持つことを必要とする点である。スクリーンが仮想空間を表現するために使われるだけでは不十分で、実際の場所と意味のある関係を持たなければならない」としている。

このあたりは、空間コンピューティングが目指す姿はあくまでMR技術による現実へのインタラクティブな没入化であり、IoTなども包含することを示している。

Appleは、今回のVisionProの利用シーンは屋内と想定しているが、現実空間の事物とインタラクティブに情報連携するユースケース、例えばHoloLensのデモにあったような、車を認識したらエンジンやシャシー構成など内部構造が重畳して表示される、といったシーンは、発表会のデモではあまり見られなかった。

AppleのAR技術ARKitのポテンシャルを考えれば十分可能であるはずなので、今後開示される情報で斬新なスタイルを披露する可能性がある。製品価格は高額になるが、「できること全部入り」の、車でいうF1のようなマシンを業界に投じることで、新たな足場を築くかもしれない。

2024年に登場するVisionProは、「空間コンピューティング元年」の呼び水になるだろうか。今から楽しみに待ちたい。

著者

岡本 茂久氏

日本アイ・ビー・エム システムズ・エンジニアリング株式会社

イノベーション・ラボ

シニアITスペシャリスト

TEC-J ステアリング・コミッティーのメンバー

1997年、日本IBMに入社。2005年から日本アイ・ビー・エム システムズ・エンジニアリングに出向。エンタープライズ・コラボレーションのミドルウェア、ECソリューション、グラフデータベース、WatsonAPIなどのAIソリューションを担当。現在はAR/VRのビジネス活用の先進事例やメタバースプラットフォーム構築のリードを中心に取り組んでいる。

*本記事は筆者個人の見解であり、IBMおよびキンドリルジャパン、キンドリルジャパン ・テクノロジーサービスの立場、戦略、意見を代表するものではありません。

当サイトでは、TEC-Jメンバーによる技術解説・コラムなどを掲載しています。

TEC-J技術記事:https://www.imagazine.co.jp/tec-j/

[i Magazine・IS magazine]